La méthode Méliès

Avant le tournage de ce petit film j’ai procédé à certains tests de tracking d’objets n’utilisant qu’une seule caméra, en voici deux exemples:

Après quelques réflexions j’ai décidé de capturer l’animation faciale dans une prise séparée. Dans l’image, la caméra référence qui a aussi enregistré l’audio des prises. Afin d’obtenir des rushes assez clairs j’ai allumé les deux écrans d’ordinateurs en face de mon visage et j’ai ajouté un tube LED au sommet des écrans.

Dans les premiers tests, la Keyblade en bois n’avaient que des points noirs peints sur sa surface ce qui a provoqué des difficultés pendant la phase de tracking. Les problèmes se sont alors envolés après avoir ajouté des points blancs.

A l’origine je voulais filmer toutes les phases en une fois, le tracking de la keyblade, de la tête et la capture d’animation faciale en même temps. Malheureusement mes dons en rotoscopie n’étaient pas au niveau pour supprimer le rig de capture faciale de l’image. Je pense que le prochain design du casque sera plus petit.

Le film a été tourné avec mon vieux Lumix GH1 hacké et l’objectif 20mm F.1.7. L’environnement a été capturé avec un objectif Peleng 8mm, la caméra fixée sur une tête panoramique Nodal Ninja 3, afin d’être utiliser au moment du rendu pour illuminer et gérer les reflets pour les éléments 3D.

Une fois le tournage effectué, j’ai pu m’atteler au processus de tracking. Rien de bien compliqué ici étant donné que tout a bien été préparé lors du tournage.

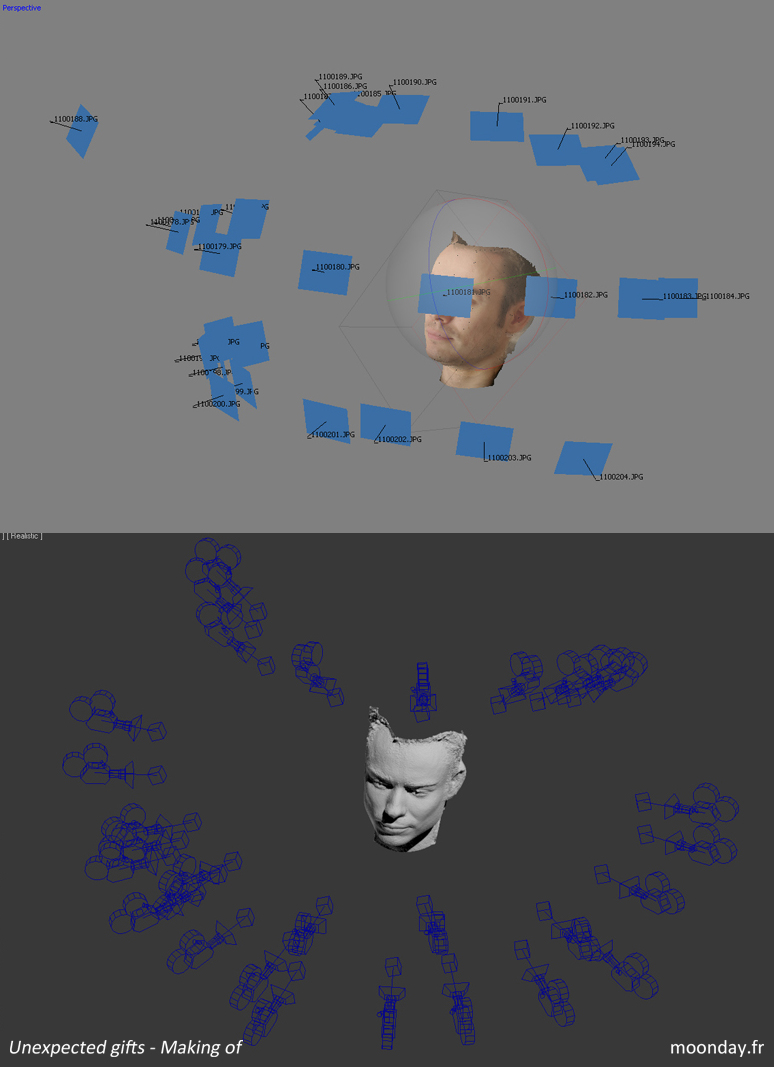

La tête de Lune est basée sur un scann de ma propre tête fait à l’époque pour un autre projet, en utilisant Agisoft Photoscan. Il en est de même au sujet des dents pour lesquelles j’ai eu l’aide de ma dentiste. Sur le moulage qu’elle a créé, j’ai peint un motif afin d’obtenir plus de détails lors de la phase de tracking dans Agisoft Photoscan, méthode découverte sur le forum CG feedback, les modèles générés étaient vraiment détaillés.

Un dernier mot sur ce premier plan. L’élément m’ayant donné le plus de fil à retordre était la chaîne au bout de la Keyblade. J’ai passé plusieurs jours à lancer des simulations physiques en modifiant l’échelle du monde, en testant différentes valeurs, options etc. Au final la chaîne explosait toujours à un moment. J’ai même tenté d’utiliser une simulation de vêtement mais là on approchait le niveau zéro de la crédibilité.

La solution: utiliser les contraintes charnières comme au bon vieux temps de Reactor. C’est pour cette raison que les maillons de la chaîne semblent plus collés entre eux que libres.

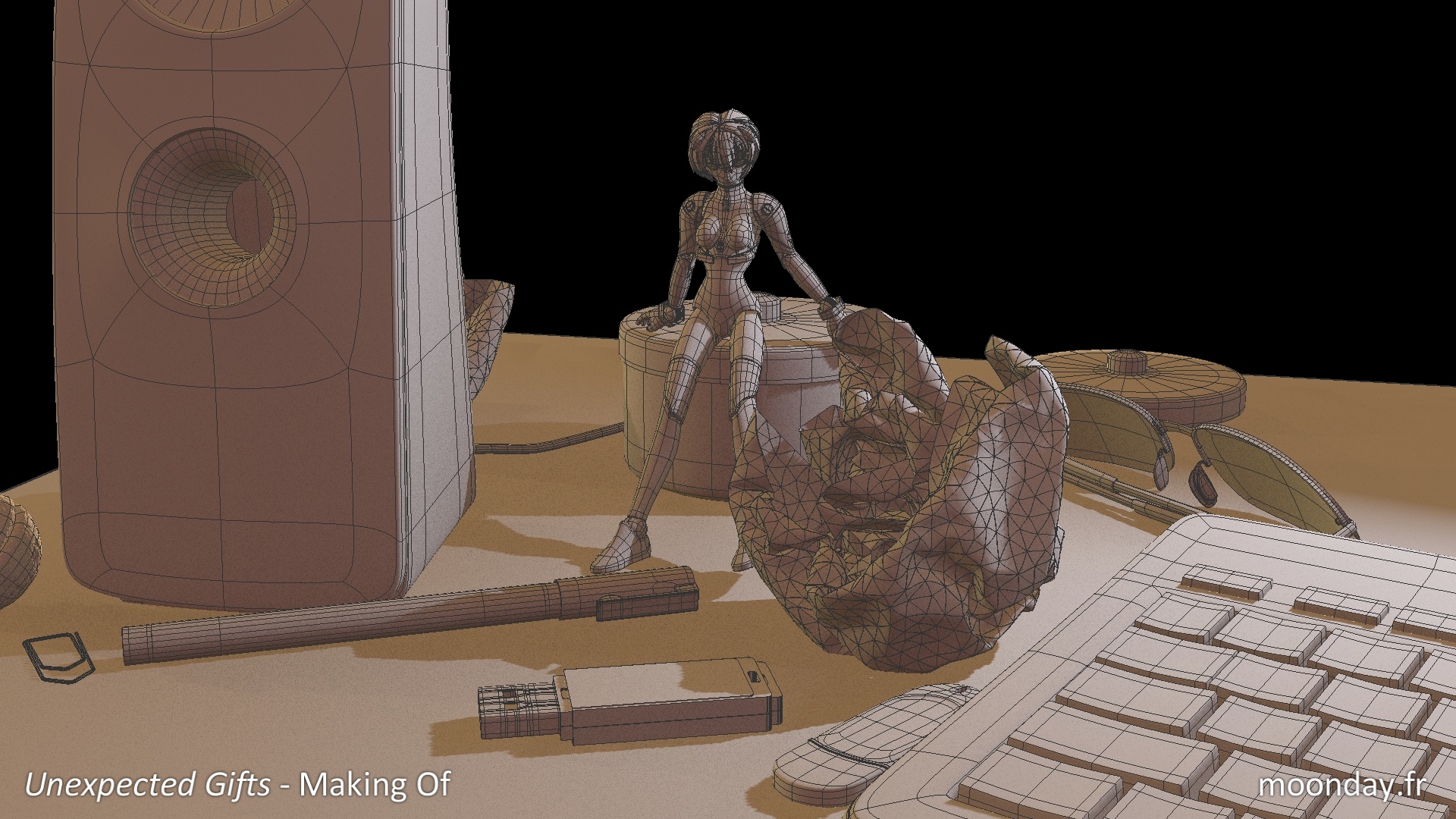

Le Monde imaginaire

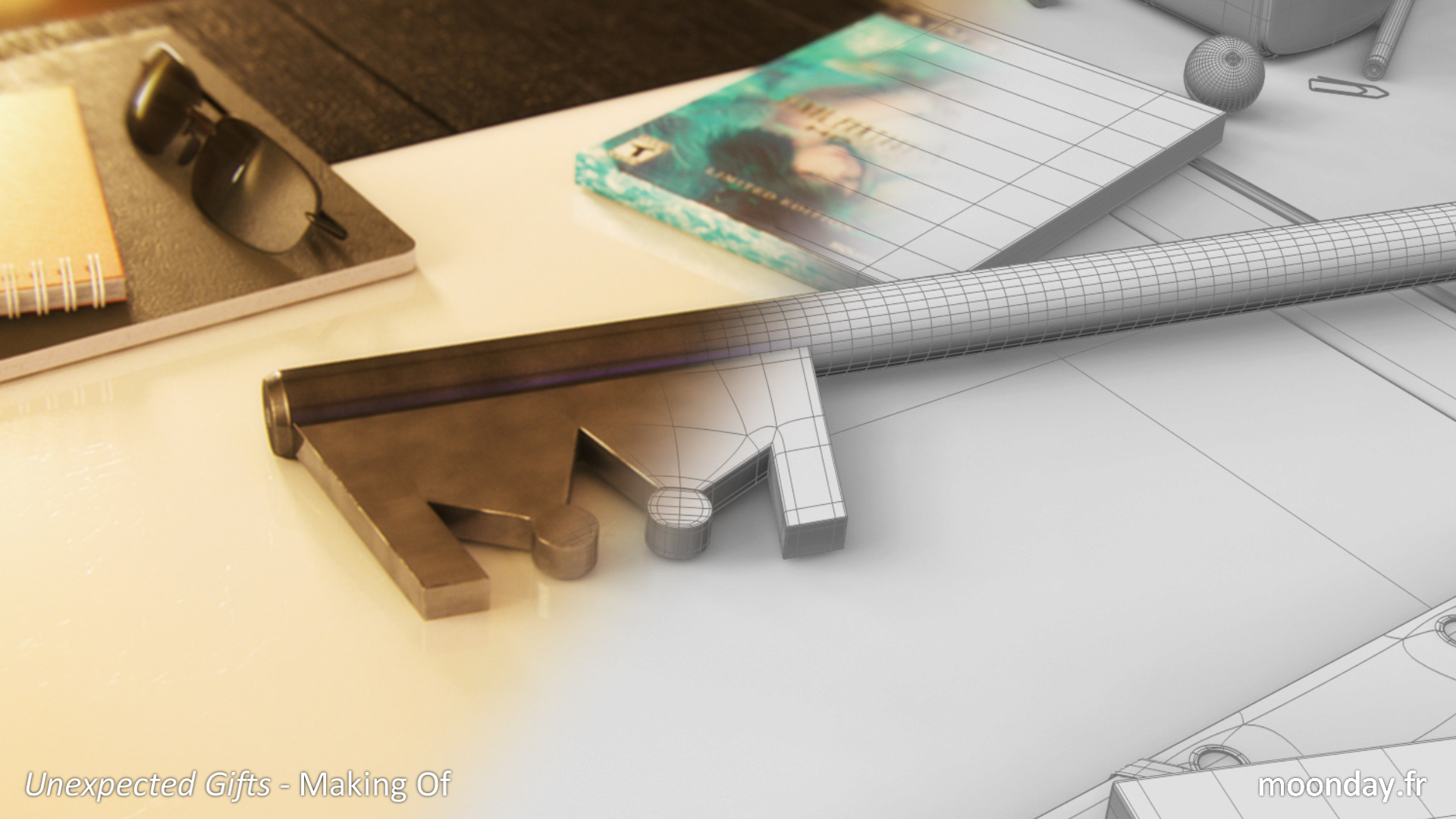

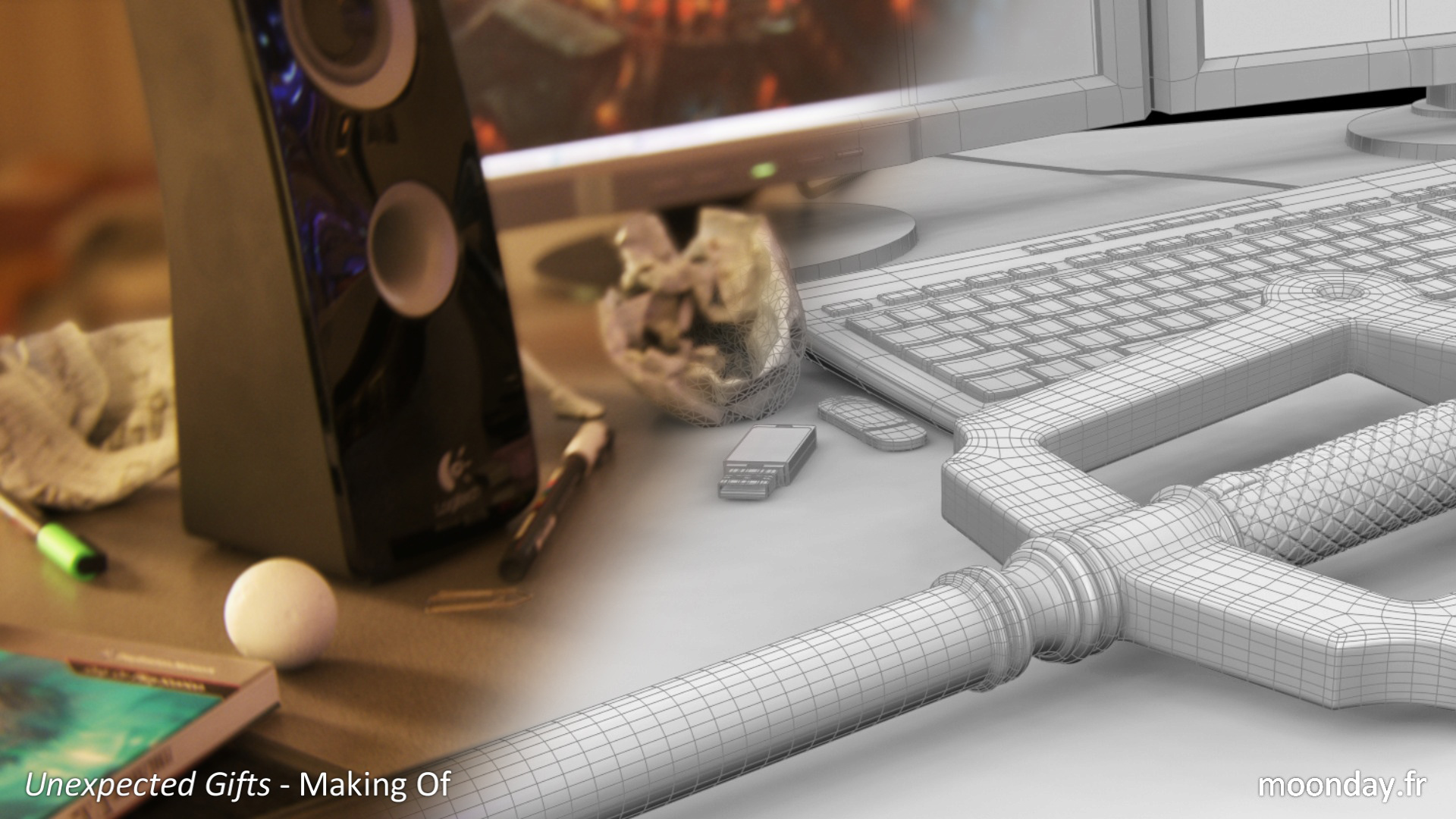

C’était assez amusant de créer à nouveau des objets de la vie courante en 3D. La plupart des modèles sont basés sur de vrais objets peuplant mon bureau et ma chambre, la figurine Revoltech Rei Ayanami a été très utile.

A propos des boules de papiers froissées, je vous invite à suivre ce tuto de Matt Chandler!

Alors que je travaillais sur les rendus du projet, j’ai découvert quelques faits intéressants concernant Mental Ray

1. Rendre des textures procédurales prend plus de temps que de rendre des bitmaps. Pour le bureau du second plan j’ai utilisé une map cellulaire dans les onglets diffuse, glossy et bump. Je trouvais alors tout à fait normal d’attendre 20 minutes pour que mon image rende (hé oh, on est sur Mental Ray 😉 ) mais après une erreur pendant un test je me suis rendu compte que ce n’était pas du tout normal d’attendre aussi longtemps.

J’ai donc “baké” la map cellulaire en utilisant la fonction “render to texture” et en utilisant la map obtenue les temps de rendus sont passés sous la barre des 10 minutes par image. Ce doit être quelque-chose dont les pros sont au courant et que je viens juste de découvrir. Comme quoi, on est toujours un peu noob quelque part.

2. Les Elements de Rendu dans Mental Ray prennent l’Éternité à rendre. Sans commentaires.

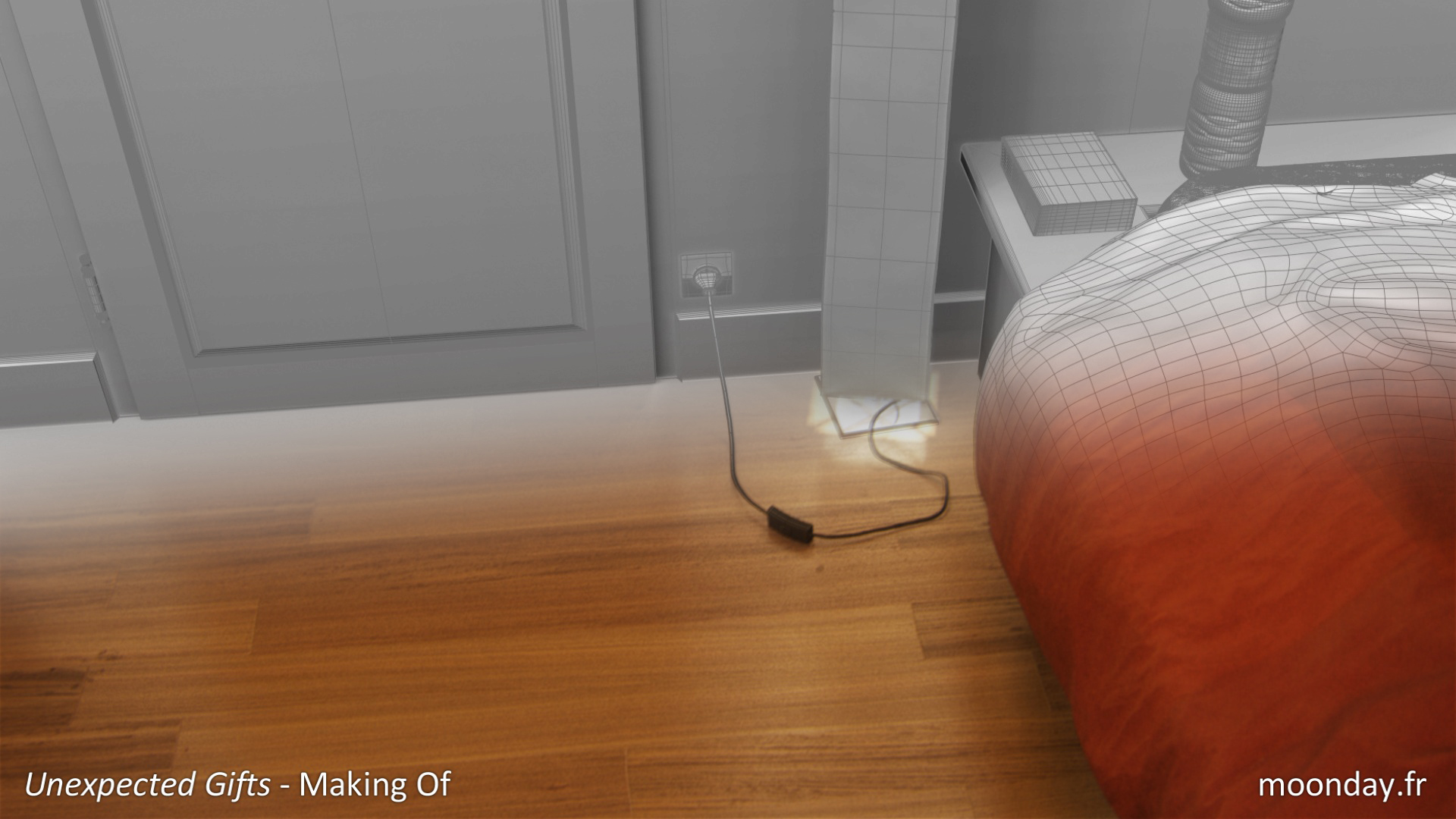

3. Utilisez le moteur de rendu Quicksilver (si si). Il s’agit du moteur le plus rapide que j’ai découvert pour calculer mes passes de Z-depth, seulement quelques secondes (moins de 5). Ce moteur est aussi très utile pour rendre des séquences filaires ou turntables comme celles présentes dans ce making of, il remplace a présent le maxscript “Power Preview“.

4. Astuce pour le flou de mouvement: C’est un fait, actuellement, rendre des images 3D avec du flou de mouvement sous Mental Ray prend du temps, voir quelques années. Même en utilisant les “unified samples”. Exporter une passe de vélocité afin d’ajouter du flou de mouvement en compositing à l’aide de plugin et sans soucis visuels n’est non plus pas possible. Bien entendu des plugins comme Spotmask permettent de créer des passes de vélocité propres mais comme expliqué récemment, si on ne possède pas de Delorean ou de TARDIS dans son bureau et qu’on s’entête à utiliser Mental Ray, on risque de dépasser la limite de temps imposé par son client.

Ma solution: Une fois que toutes les passes de base sont compositées, j’exporte une séquence image que je projette sur la géométrie de base de ma scène à l’aide du modificateur “Camera mapping”. Les matériaux sont auto-illuminés, toutes les lumières, ombres et contrôleurs d’exposition désactivés. Il ne reste qu’à activer le flou de mouvement dans le moteur de rendu. Cette technique a été utilisé sur le 3ème plan du film et j’obtenais des temps de rendus allant au maximum à 10 secondes par image pour du vrai flou de mouvement 3D.

Mais pourquoi se compliquer la vie? Pour obtenir un peu plus de contrôle sur ces rendus sans avoir à tout recalculer s’il y a un soucis dans une image ou avec un objet par exemple, ou encore si les paramètres de flou de mouvement donnent trop de grain.

Encore une méthode de noob mais je suis persuadé que cette solution doit exister et doit être automatisée sur des logiciels de compositing avancés comme Nuke.

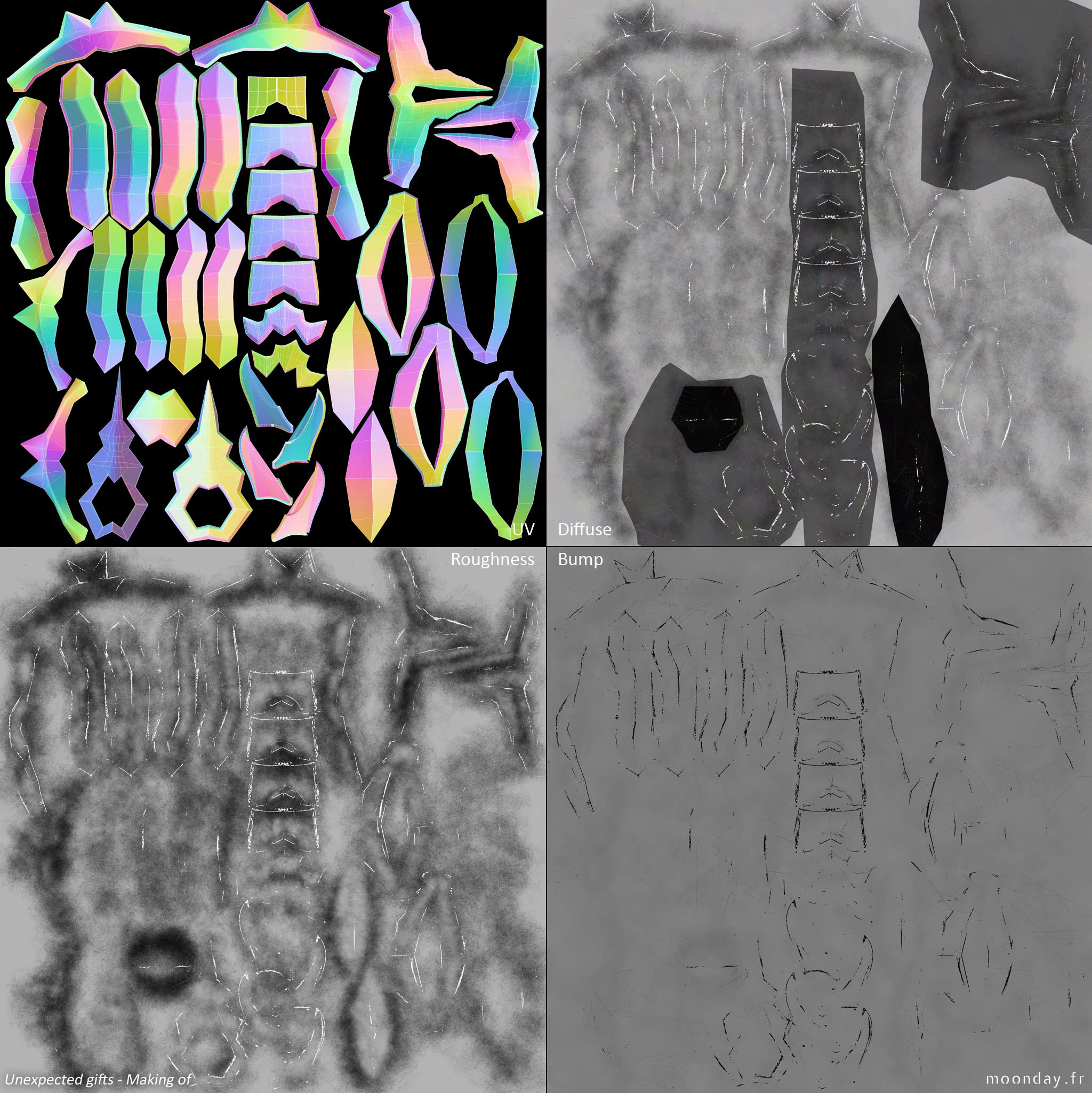

Un petit mot sur le texturing: J’ai changé mon workflow habituel pour un plus rapide.

Jusqu’à présent, lorsque je travaillais sur un modèle complexe comprenant plusieurs parties, je texturais chaque élément un après l’autre (oui, c’était looong). Pour l’armure de Terra et sa Keyblade j’ai fusionné toutes les parties de leurs mesh en un seul. Des deux modèles résultant j’ai exporté les informations de coordonnées de texture puis j’ai à nouveau détaché les éléments comme ils étaient à la base (armure, combinaison, bottes, etc.) De cette façon, une fois dans Photoshop j’ai pu peindre les différentes textures dans un seul fichier et assurer ainsi une constance entre les différents éléments. Oui, avant le 14 juin 2014 je pensais que cette méthode ne s’appliquait qu’aux modèles low poly pour le jeu vidéo. (…)

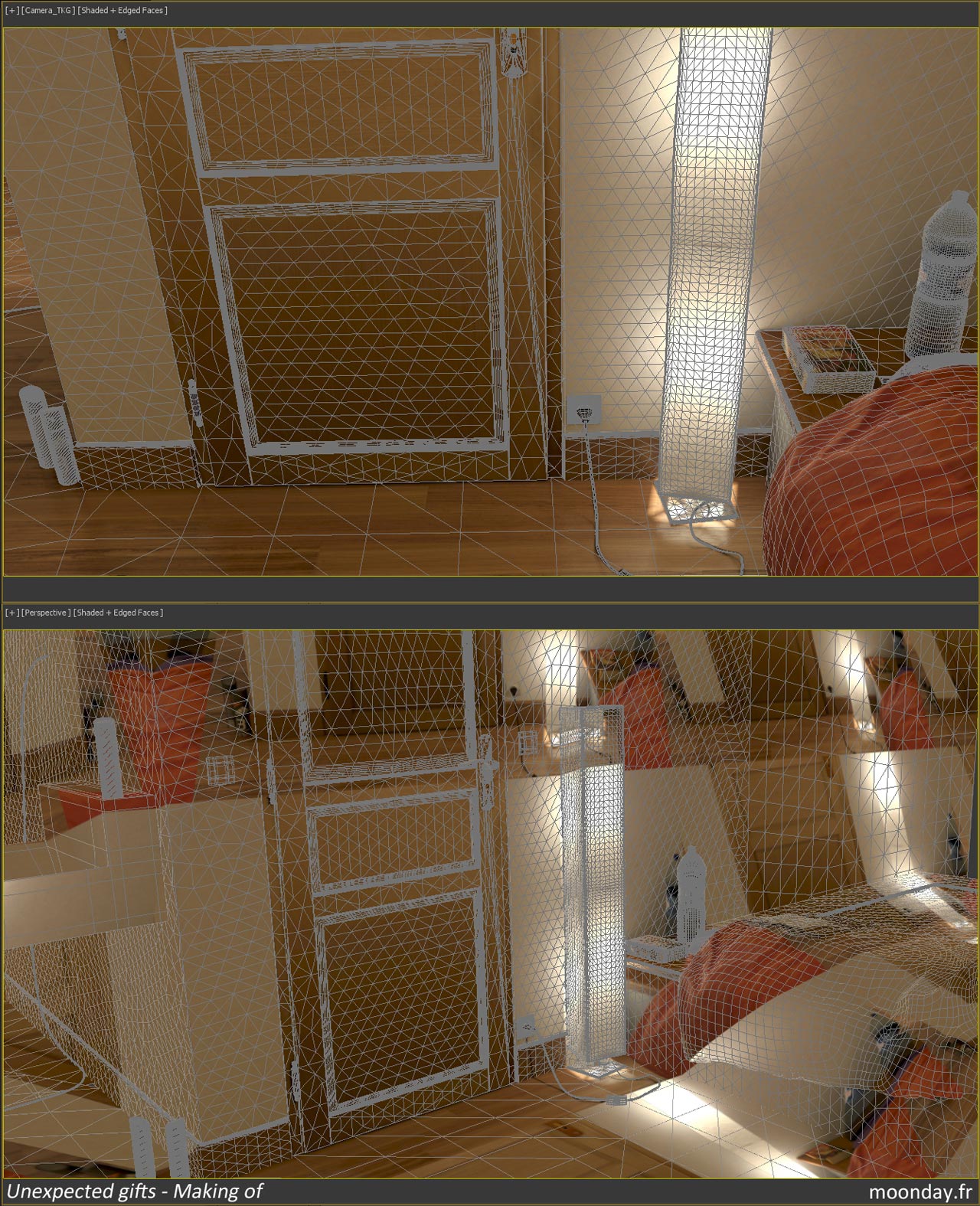

Le second et troisième plans ont utilisés des méthodes différentes pour l’animation de leur caméra. Dans le deuxième plan il s’agit d’une caméra animée manuellement avec en plus des contraintes de bruit dans la position et la rotation. Pour le troisième plan, j’ai rempli ma chambre d’éléments contrastés, de motifs et je m’y suis déplacé le GH1 à la main. Après avoir tracké le mouvement de la caméra j’ai pu obtenir un déplacement type caméra portée très naturel. L’inclinaison de la caméra a ensuite été ajustée pour coïncider avec l’animation de Terra.

Le modèle de Terra a été créé en me basant sur des illustrations de Tetsuya Nomura et des captures de vidéos tirées des jeux “Kingdom Hearts II” et “Birth By Sleep”. J’ai ajusté les proportions du personnage afin de donner l’impression qu’une personne réelle portait un costume.

Toutes les vidéos de ce Making Of et bien d’autres, compilées dans cette vidéo:

Ce projet n'est aucunement lié à la société Square-Enix. C'est un projet purement parodique et fictif. Tous les éléments du film ainsi que ceux présents dans ce Making Of ont été créés par moi-même. - Nicolas Brunet / Juillet 2014 -